如同飞机不是飞得更高的鸟儿一样,人工智能也并不是更聪明的人。在大数据出现之前,计算机并不擅长解决需要人类智能的问题,但是今天这些问题换个思路就可以解决了,其核心就是变智能问题为数据问题。由此,全世界开始了新的一轮技术革命——智能革命。

鸟飞派:人工智能1.0

“达特茅斯夏季人工智能研究会议”:事实上这仅是一次头脑风暴式的讨论会,其意义不在于产生了什么主要思想,而是提出了问题,讨论了当时计算机尚未解决甚至尚未开展研究的问题,包括人工智能、自然语言处理和神经网络等。

人工智能1.0方法论:先了解人类是如何产生智能的,然后让计算机模拟人进行思考。

而实际上,按照图灵测试的方法,机器智能最重要的是解决人脑所能解决的问题,而不在于师傅需要采用和人一样的方法。

对于“人工智能是否需要模拟人”这件事的看法,是当下人工智能过热时期,甄别真正的学者专家、民间科学家、门外汉或者技术概念掮客的试金石。

数据从量变到质变

从某种意义上讲,2005年是大数据元年,谷歌以巨大优势打败了全世界所有机器翻译研究团队。谷歌翻译的发明人奥奇博士采用比其他团队多出上万倍的数据训练了一个六元模型,而当时大部分团队的数据量只够训练三元模型。

大数据的特征

体量大、多维度、完备性

及时性不是大数据必需的特征,但是有了及时性可以做很多过去做不到的事情,比如城市的智能交通管理。

为什么是”big data“而不是”large data“?很多通过收集和处理大量数据的论文都采用large或者vast两个词,比如题目中经常是“lagre scaled” “vast data” “large amount”,但是很少用big。那么big、large和vast区别在哪?large和vast在程度上略有差别,厚实可以看成very large。而big更强调的是相对小的大,是抽象意义上的大,而large和vast常常相容体量的大小。仔细推敲 big data 这种说法,我们不得不不说这个提法非常到位。它最重要的是传递了一种信息——大数据是一种思维方式的改变。再有大数据前,计算机并不擅长解决需要人类智能来解决的问题,现在换个思路就可以解决,其核心在于变智能问题为数据问题。

我们对大数据重要性的认识不应该停留在统计、改进产品和销售,或者提供决策的支持上,而应该看到它和摩尔定律、数学模型一起导致了机器智能的产生。而机器智能一旦产生和人类相似的智能,就将对人类社会产生重大的影响。

深度学习与摩尔定律

让计算机能够产生智能的三个要素是数据、数学模型和硬件基础,所以有了海量数据,就需要解决如何建立数学模型和硬件基础是否可以承载的问题。

什么是机器学习

很多问题可以用非常确定的数学模型来描述和解决,只要吧相应的公式用计算机语言写一遍,代入参数,就能计算结果。但更过问题的解决方法是不确定的,即使我们找到了相应的数学模型,也找不到该代入什么参数,比如语音识别、人脸识别。让计算机从大量的数据中自己学习得到相应的参数,这个过程就是机器学习。

机器学习特点

- 有一个确定目标,“期望值最大化”(expectation maximization)这里的期望值未必是一个具体的数字,而是一个或一组目标函数

- 效果取决于三个因素:不断学习的深度、学习时使用的数据量、数据的质量

我们希望数据量要尽可能大,最好还很干净、无噪声,同时还能迭代很多次,但是在工程上这很难做到。首先,完全不经过过滤的数据难免会混入噪声,而人工滤除噪声的成本很高。其次,机器学习的算法都比较“慢”,即计算复杂度太高。

解决方案:

- 浅层机器学习:采用大量的数据,较少的迭代次数,训练一个较简单的模型

- 深层机器学习:采用复杂模型,较少数据,经过很多次迭代训练出准确的小模型

事实证明,采用大量数据,较少“迭代”训练出来的“较粗糙”的模型要好于少量数据、深层学习、精耕细作得到的模型。

深度学习与谷歌大脑

作为一个深度学习的工具,谷歌大脑特殊之处在于:首先找到了一种方法,将大型模型上百万参数同时训练的问题简化为能够根部到上万台服务器上的小问题,还找到了一些对大型模型并行训练收效比较快的训练算法。其次,谷歌大脑的成功不仅向业界展示出机器学习在大数据应用中的重要作用,而且通过实现一种机器学习并行算法,向大家证明了深度学习所带来的奇迹。

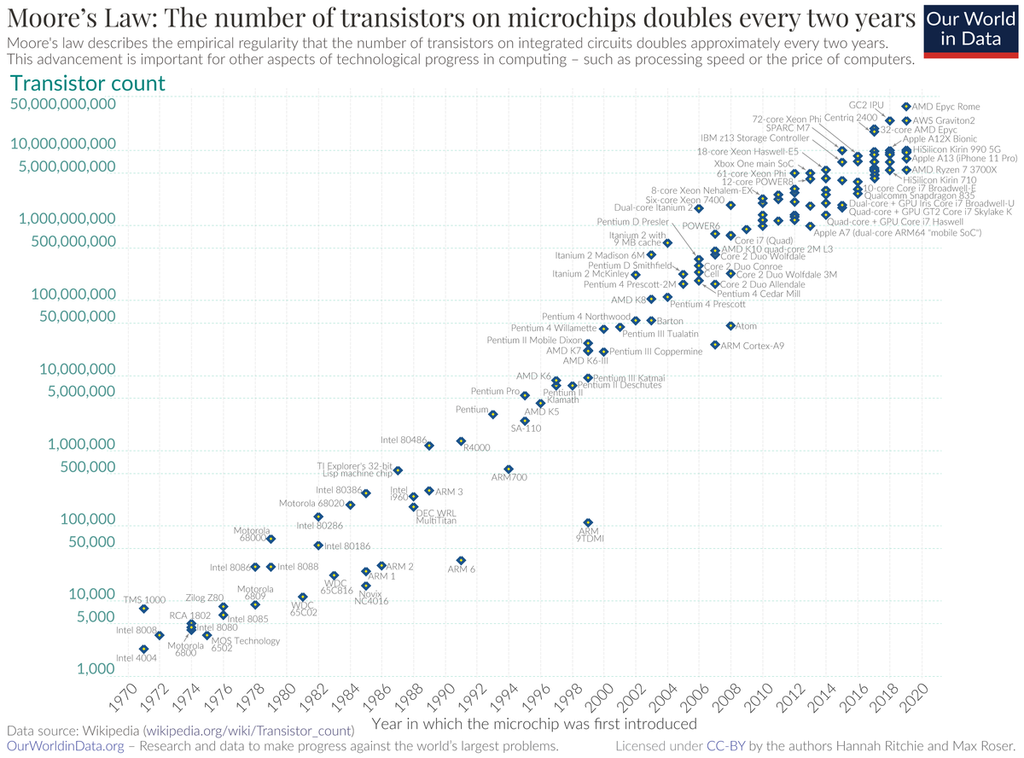

摩尔定律的馈赠

摩尔定律带来的结果是,在过去半个多世纪里,计算机处理器的性能增长了上亿倍,耗电量缺下降到百分之一。从能量的角度来看,摩尔定律其实反映出人类在单位能耗下,所能完成的信息处理能力的巨幅提升,而这是实现人工智能的基础。

今天人工智能的成就,在一定程度上和我们实现了深度学习这个算法工具优芙安,而它能够得以实现,在很大程度上则要感谢摩尔定律。虽然最近几年集成电路的绝对性能很难再按照摩尔定律所预测的速率增长,但是单位能耗的性能依然在快速提高。

评论 (0)